発表スライドから得られる知識

発表スライドを見ると、以下を "完全に理解" できます✌️

- プラットフォーム設計導入のために、横断的コミュニケーションが必要である

- プラットフォームエンジニアリングで、マルチプロダクトの生産性を支える

- プラットフォームエンジニアリングで、各マイクロサービスの生産性を支える

イベント名

オッス!

オラ長谷川!✋🏻

『マルチプロダクトの組織でマイクロサービスアーキテクチャを支えるCICDプラットフォーム設計』

ていうテーマで、 Findy 開発生産性 Conference に登壇したぞ!

発表スライド

みんな!

スライドぜってぇ見てくれよな!

『Findy開発生産性Conference』の発表資料です✊🏻

— 長谷川 広樹 (地下強制労働者) (@Hiroki__IT) June 28, 2024

オラたちのプラットフォームエンジニアリング事例を紹介してっから、ぜってぇ見てくれよな!✋🏻#開発生産性con_findyhttps://t.co/DjqztPn9z4

ちな、発表内容はこの記事にも関連してるぜ!

イベントレポート

@shinri_koda さんが書いてくれたイベントレポートもぜってぇ見てくれよな!✊🏻

(ワードセンスがあり過ぎて、個人ブログ始めたら人気になりそう)

センスある面白い一文😂

— 長谷川 広樹 (地下強制労働者) (@Hiroki__IT) July 6, 2024

これは、今すぐに日記ブログを始めるべき https://t.co/9SVo516apI pic.twitter.com/MApAcqxWoQ

謝辞

感謝するぜ!

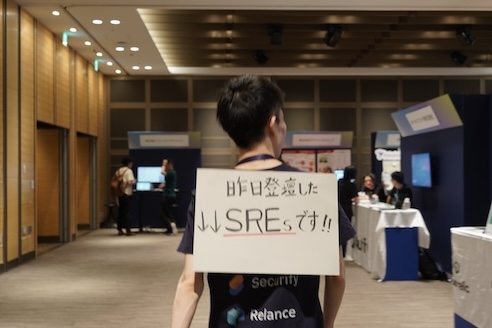

イベントで出会えた全ての方々に!!!🫶🏻

株式会社スリーシェイクのブースにお邪魔させていただきました🙌#3shake_inc pic.twitter.com/W7ufgaKfbS

— すてにゃん (@stefafafan) June 29, 2024